Indiscutiblemente, la tecnología ha sorprendido a toda la humanidad; las tecnologías expuestas en este special issue de revista Technology julio-agosto 2021 se trata de avances tecnológicos que en los años 1980 parecían como extraídos de películas de ciencia ficción, pero que intrépidas personas y compañías los hicieron realidad justo al principio de los 2000 e incluso en la década recién terminada.

Con motivo de la edición no. 50 de la revista Technology, quedan expuestas las 50 innovaciones desarrolladas en este siglo, que están cambiando al mundo. Conózcalas debajo.

Accede a las historias más relevantes de negocios, bienestar y tecnología. Entérate de nuestros rankings y eventos exclusivos. Suscríbete y recibe en tu correo el mejor contenido de Mercado.

La banda ancha o acceso a internet de alta velocidad permite a los usuarios acceder a internet y a los servicios relacionados a velocidades significativamente más rápidas que las disponibles mediante los servicios de discado (dial-up, en inglés). Las velocidades de banda ancha varían significativamente, dependiendo de la tecnología y del nivel de servicio contratado.

Los servicios de banda ancha para consumidores residenciales proveen típicamente velocidades más rápidas de descarga de datos (de Internet a su computadora) que las velocidades de carga de datos (de su computadora a Internet).

La primera vez que apareció un bitcoin fue el 3 de enero de 2009. En ese entonces, nadie se imagino que “un dinero” basado solo en información cibernética tenía el potencial de poner de rodillas al sistema financiero mundial, cuestionando los tres grandes pilares de la práctica monetaria del mundo capitalista: el respaldo fiduciario, la regulación estatal y el curso legal local con convertibilidad internacional.

Es que el mítico, y nunca visto, Satoshi Nakamoto entiende que bitcoin rompe con la hegemonía que los bancos centrales, en especial la Reserva Federal estadounidense, tiene en cuanto a la medida de valor que se le da al producto de mercado y al trabajo. Hoy, como es natural, los bancos centrales y reguladores miran con recelo este avance, que por un lado puede eliminar el costo global de remesas, y por otro puede ser un activo refugio muy efectivo para delincuentes.

Cada registro digital en el hilo se llama bloque (de ahí el nombre), y permite que un grupo abierto o controlado de usuarios participe en el libro electrónico. A su vez, cada bloque está vinculado a un participante específico.

Blockchain solo se puede actualizar por consenso entre los participantes en el sistema, y cuando se ingresan datos nuevos, nunca se pueden borrar. Existe un registro verdadero y verificable de todas y cada una de las entradas realizadas en el sistema. La información contenida en un blockchain existe como una base de datos compartida, y continuamente reconciliada. Esta es una forma de usar la red que tiene beneficios obvios.

Cuando Steve Jobs anunció la venta del iPhone en junio de 2007, pocos se imaginaron que en la palma de la mano sus usuarios podrían centralizar toda su vida digital, desde las más íntimas particularidades de la persona, hasta las tareas más complejas del trabajo, la gestión de empresas y la inversión.

Ahora, es popular el dicho que dice que un teléfono inteligente de 500 dólares tiene más capacidad que la computadora que calculó los factores que pusieron a los primeros astronautas estadounidenses en la luna. Todo empezó con el iPhone que, aunque había otros teléfonos inteligentes como la Palm y el BlackBerry, introdujo innovaciones como un entorno de aplicaciones que los usuarios podían descargar a voluntad.

En un planeta de 7,000 millones de personas, hay al menos 8,000 teléfonos inteligentes.

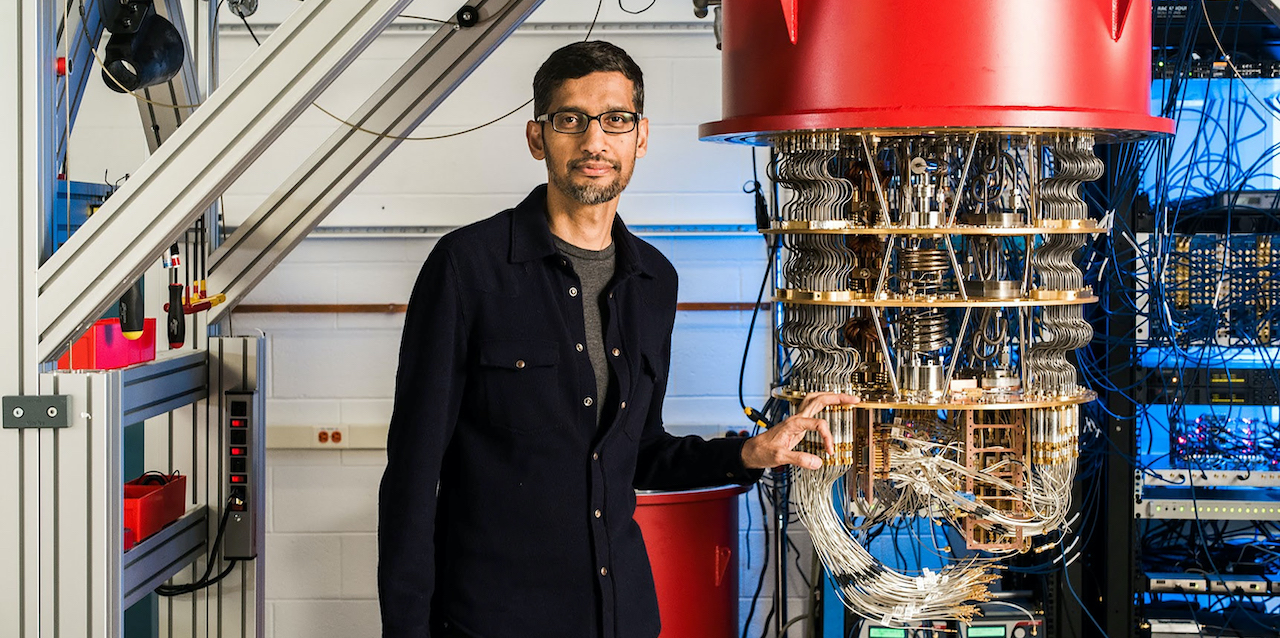

Es la que ejecuta sus programas y comandos funcionando como partículas atómicas y subatómicas. Como el hardware y el software interactúan de la misma manera, en teoría, en la que los tejidos humanos se relacionan, sus capacidades de almacenamiento y desempeño prometen ser muy superiores a los de la computación clásica. Ahora bien, el reto consiste en hacer escalable esta tecnología.

La computación cuántica utiliza el qubit como unidad básica, en vez del bit tradicional. ¿Qué implica esto? La multiplicidad de estados de una información facilita que un computador de 30 qubits realice 10,000 millones de operaciones en coma por segundo, más sencillo, la capacidad de 5,800 millones de consolas PlayStation. Tomando en cuenta que a las computadoras se les exigirá más con la implementación del 5G y el internet de las cosas, resulta interesante.

En su bestseller 21 Lecciones para el siglo 21, el historiador Yuval Noah Harari, catedrático de la Universidad de Tel Aviv, declaró que quien quiera acceder a información de calidad tendrá que pagar por ella directamente, con preferencia por medio del modelo de las suscripciones. Muchos consumidores le han tomado la palabra al celebrado autor.

El negocio de la suscripción B2C a medios de comunicación se encuentra en $ 50,000 millones de dólares al año, de acuerdo con el Social Media Suscription Global Market Report 2020-2030, que mandan a editar gigantes como Amazon Inc. y Netflix.

El Suscription Global Market comprende que la cifra mencionada se puede duplicar en los próximos años, por eso Twitter busca su propia tajada del pastel con Blue, un servicio premium que perseguirá a los millenials con empleos bien remunerados, quienes demandan de mejores experiencias en las redes sociales y tienen ingresos para sustentar esa aspiración.

La industria de las baterías de litio suma $ 51,300 millones de dólares, de acuerdo con el Global Lithium-ion Power Battery Market Insights Forecast 2026. Aunque los smartphones generan la demanda, es la movilidad eléctrica la que ha convertido al litio en el oro blanco, el metal que desafía al petróleo por la supremacía de la industria química.

A nivel global, solo el 2,6% de los vehículos que se venden cada año son eléctricos, no obstante, en la medida en la que los gobiernos regulen a favor de su uso con facilidades fiscales o, más bien, prohíba las unidades basadas en carburantes, el 20% de los movilizados de las calles del mundo encenderá con electricidad, indica el Global EV Outlook 2020, reporte que no solo habla de los carros, sino que también contempla las motocicletas, las patinetas, las camionetas y hasta los camiones.

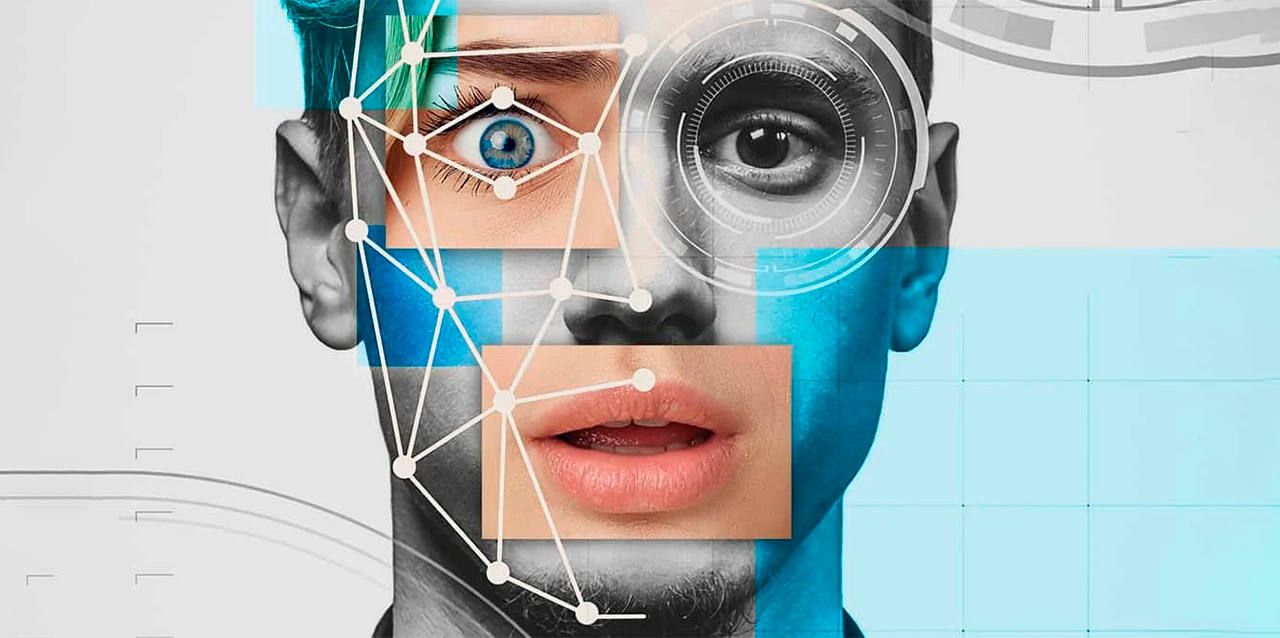

La firma Technavio reconoce que el negocio de los sistemas de reconocimiento facial aumentará en $ 3,350 millones de dólares, desde el 1 de enero de 2020 hasta el 31 de diciembre de 2024. El reporte reconoce que pocas innovaciones han hecho tanto por las procuradurías de justicia, la labor policial, la prevención de delitos y la lucha contra la trata de personas.

Big Data es la tendencia tecnológica que permite a los sistemas de reconocimiento facial acumular e instrumentalizar los trillones de datos que se pueden acumular en una nación. Puesto que se registran todas las protuberancias fáciles, en teoría, es posible identificar a un niño que se les extravió a sus padres, a un sospechoso de homicidio o a un terrorista buscado a escala internacional.

¿Cómo funciona? Utiliza una serie de algoritmos, muchos de ellos, para destacar los millones de rasgos que pueden caracterizar a los rostros humanos. El menú de opciones aplica a diferencias evidentes como el color de los ojos y a minucias imperceptibles a la vista como la distancia entre la nariz y la boca. Cada distinción recibe un valor matemático obtenido de los números infinitos, que permite encontrar lo que se busca, a partir de una referencia, es decir, a partir del rostro colocado para ser encontrado.

Fue creado en 2005 por tres jóvenes que se conocieron mientras trabajaban en PayPal: Steve Chen, Chad Hurley y Jawed Karim. Solo un año más tarde, esta plataforma fue vendida a Google Inc. por 1,650 millones de dólares. En mayo de 2006, YouTube ya había alcanzado los 2,000 millones de visualizaciones por día y se había posicionado en el número 10 de los sitios web más visitados en Estados Unidos.

Según cuentan los fundadores, la idea de YouTube surgió en una cena mientras hablaban sobre cómo podían compartir los vídeos de una fiesta, pues eran demasiado pesados para compartirlos por correo. Así, surge la idea de crear un sitio web donde poder compartir y ver vídeos.

Steve Chen es cofundador y director técnico de YouTube. Antes del lanzamiento de YouTube, Chen trabajó desde muy joven para Facebook, y también para PayPal. En 2006 fue nombrado por Business 2.0 como una de “Las cincuenta personas que importan hoy” en negocios.

En la actualidad, la plataforma de 2,000 millones de usuarios cambia la forma de hacer televisión abierta. La colocación de anuncios ha elevado el valor de la página hasta los $ 170,000 millones de dólares.

La IA agrega inteligencia a productos existentes. En la mayoría de los casos, la inteligencia artificial no se venderá como aplicación individual. En su lugar, los productos que ya utiliza serán mejorados con recursos de inteligencia artificial, de forma muy similar en que se agregó Siri como característica a una nueva generación de productos de Apple.

La automatización, las plataformas conversacionales, los bots y las máquinas inteligentes se pueden combinar con grandes cantidades de datos para mejorar muchas tecnologías en el hogar y en el lugar de trabajo, desde inteligencia de seguridad hasta análisis de las inversiones.

Se adapta a través de algoritmos de aprendizaje progresivo para permitir que los datos realicen la programación. La inteligencia artificial encuentra estructura y regularidades en los datos de modo que el algoritmo adquiere una habilidad: el algoritmo se convierte en un clasificador o predictor.

De este modo, así como el algoritmo puede aprender a jugar ajedrez, puede aprender también que producto recomendar a continuación en línea.

El prestigioso programa de asistencia circulatoria mecánica del Hospital Universitario de Bellvitge, el más activo de España en implantación de corazones artificiales, ha dado un nuevo paso adelante con la implantación de su primer corazón artificial total. Se trata de una intervención muy excepcional en España, donde hasta ahora sólo se había implantado un dispositivo de las mismas características con éxito.

El paciente es un hombre de 30 años con fallo de los dos ventrículos del corazón e hipertensión pulmonar, afectaciones que le impedían recibir un trasplante de corazón o una asistencia ventricular mecánica (corazón artificial que sólo sustituye la función de uno de los dos ventrículos). Ante esta situación, y dada la extrema gravedad de su estado, se le indicó la implantación, con carácter temporal, de un corazón artificial total.

En una intervención quirúrgica de alta complejidad que se realizó 27 de mayo de 2019, los cirujanos retiraron los dos ventrículos del corazón del paciente (dejando intactas las aurículas, la aorta y la arteria pulmonar), implantaron en su lugar las conexiones para el corazón artificial, y colocaron a continuación el nuevo dispositivo, que incluye dos ventrículos artificiales que sustituyen a los extirpados. El sistema implantado se conecta mediante dos tubos a una consola portátil externa.

Los impulsos que se generan en la consola externa se transmiten por un sistema de aire y vacío a los ventrículos artificiales que activan el mecanismo de bombeo de la sangre. Esta intervención ha sido posible gracias a la gran experiencia en asistencia circulatoria mecánica (corazones artificiales) de los cirujanos cardiacos, cardiólogos y todo el equipo de profesionales de insuficiencia cardiaca avanzada y trasplante del Área de Enfermedades del Corazón de Bellvitge, que se ha complementado con una formación técnica específica para la implantación de este tipo de dispositivo.

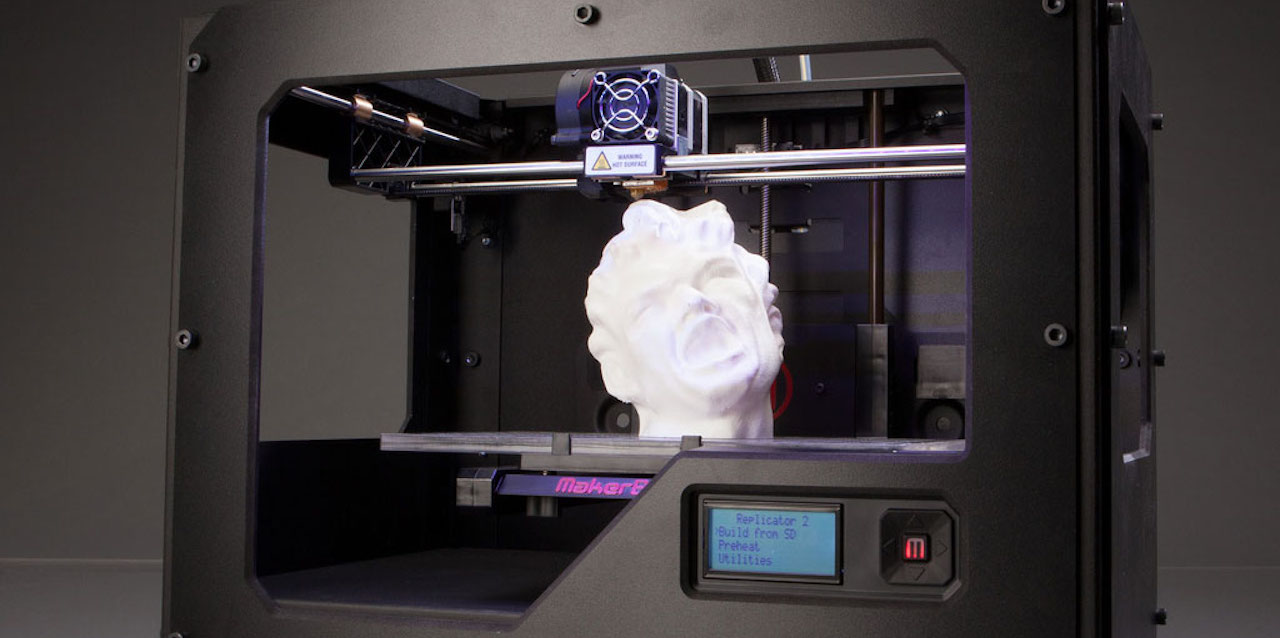

Los objetos que pueden imprimirse en 3D son múltiples y variados. Objetos caseros, maquetas, alimentos, componentes espaciales, prótesis, órganos humanos, etc. Digamos que todo lo que puedas “crear” por ti mismo podría imprimirse en 3 dimensiones. Nada se resiste a las impresoras 3D.

Es lógico pensar que estas impresoras están diseñadas para objetos pequeños, pero nada más lejos de la realidad ya que existen impresoras de grandes dimensiones que pueden incluso imprimir un edificio por piezas con sus muebles incluidos.

La propia NASA envió una de estas impresoras 3D a la Estación Espacial Internacional para que los astronautas puedan fabricar piezas que consideren necesarias en el espacio. Incluso se pueden fabricar casas mediante impresoras 3D. En China ya se ha fabricado una villa entera que ha costado unos 500€ por metro cuadrado y en tan solo unas decenas de días. La villa se fabricó por módulos en fabrica y después se colocó en el sitio donde quería el dueño.

La industria del videojuego es un negocio al alza que evoluciona paralelamente tanto en ingresos como en el desarrollo de su tecnología, para ofrecer nuevas experiencias al consumidor. Solo en 2018, este sector facturó 1,530 millones de euros y creció un 12.6 por ciento respecto al año anterior, en España, según datos publicados por la Asociación Española de Videojuegos (AEVI).

Las demandas de los jugadores a la hora de adquirir un nuevo título son tan variadas como complejas. Hay usuarios que prefieren aventuras largas y jugar de manera individual, mientras que otros deciden sumarse a partidas con cientos de jugadores “online” y demostrar sus habilidades en modo cooperativo con amigos u otros rivales.

En tan solo 5 años la industria del videojuego ha evolucionado de una manera significativa, con productos cuyo presupuesto superan al de una superproducción de Hollywood y cuentan con un guion complejo que poco tiene que envidiar al relato de una novela de ficción.

La mejora de los procesadores de las videoconsolas y la potencia de los nuevos televisores, con una resolución de imagen que aumenta cada año, han supuesto una vía de desarrollo para que las principales marcas de la industria diseñen videojuegos con un realismo que atrapa al usuario. Sin embargo, el gran reto de las empresas ahora mismo es conseguir potenciar la realidad virtual, una tecnología con un sinfín de posibilidades.

Este tipo de videojuegos ofrecen una experiencia única en primera persona a los jugadores, convirtiéndolos en los auténticos protagonistas del videojuego para trasladarlos a un mundo sin límites desde el propio sofá de su casa. Hasta el momento, los juegos de realidad virtual más exitosos han sido los de disparo en primera persona y de exploración.

Las principales marcas de videoconsolas apostaron hace menos de un lustro por crear juegos que utilizasen gafas de realidad virtual y dar una experiencia inmersiva al usuario. El mando analógico sigue cumpliendo un papel destacado en estos dispositivos, pero cada vez son más los juegos que comienzan a añadir modalidades que obliguen al jugador a levantarse y utilizar sus habilidades para completar el desafío al que se enfrenta.

La mayoría de avances en el coche autónomo se deben a un único nombre, Ernst Dickmanns, un alemán que profesor de la Bundeswehr University de Múnich y experto en inteligencia artificial que lideró la construcción del primer coche autónomo moderno.

Para ello utilizó una tecnología avanzada que combinaba la visión sacádica (un movimiento rápido del ojo, cabeza u otras partes del cuerpo de animales o dispositivos) con cálculos probabilísticos y computación paralela. En 1987 Dickmanns diseñó una furgoneta Mercedes-Benz con esta tecnología y consiguió con éxito conducir por una autopista sin conductor alcanzando velocidades de 100 km/h sin tráfico.

Más adelante, en 1994 un Mercedes 500 SEL rebautizado como ‘VAmP’ recorrió más de 1.000 kilómetros en la carretera de circunvalación que rodea la ciudad de París, incluso era capaz de adelantar a otros coches y alcanzar velocidades de hasta 130 km/h.

La computación clásica con la que funcionan nuestras laptops, móviles y demás dispositivos del mercado ya no está sola. Si te parece complicada de entender la computación cuántica, la computación neuromórfica puedes considerarla una absoluta locura. Junto con la computación cuántica, la biológica y la clásica, el mundo está siendo testigo de tecnologías emergentes que cada día muestran un potencial mayor en diferentes campos de uso.

El futuro de todas estas tecnologías es convivir reforzando aquellos ámbitos en las que la clásica no puede ayudarnos aún. La computación neuromórfica pone el foco de atención en algo que nos resulta más familiar, pero que es también muy complejo, nuestro cerebro. La mayoría ya sabemos de forma genérica cómo funciona nuestro móvil con la computación clásica.

El famoso sistema binario de 1 y 0 que tanto juego nos ha dado en las últimas décadas. Sin embargo, nuestro cerebro no funciona para nada así y ha demostrado ser una gran herramienta de resolución de problemas. Por eso, en los años 60 Carver Mead, ingeniero eléctrico del Instituto de Tecnología de Caltech consideró la opción de crear algoritmos y circuitos integrados con la misma estructura y comportamiento que el sistema nervioso de los animales.

Mead comprobó que el comportamiento de los transistores se parece a la manera en la que las neuronas se comunican entre ellas transmitiendo impulsos eléctricos mediante un mecanismo que se conoce como sinapsis neuronal. La complejidad del cerebro es tal que se ha necesitado una colaboración entre materias como la física, la microelectrónica, la biología, las matemáticas y la informática para avanzar en esos transistores analógicos con los que soñaba Mead.

En una operación que generó bastante revuelo, Microsoft compró Skype e integró el servicio dentro de sus operaciones como una división más de la compañía. El servicio de mensajería se ha posicionado como el sustituto del clásico MSN Messenger y en uno de los servicios clave dentro de la estrategia de los de Redmond. Seguramente, los creadores de Skype nunca pensaron el peso que iba a tener su servicio; un servicio que nació precisamente el 29 de agosto de 2003.

El danés Janus Friis y el sueco Niklas Zennström, creadores de Kazaa, decidieron explorar la posibilidad de extender el uso del P2P a las comunicaciones por voz y vídeo. Basándose en este planteamiento, en Tallín (Estonia), Priit Kasesalu, Jaan Tallinn y Ahti Heinla abordaron el desarrollo técnico de la idea y, en agosto de 2003, desarrollaron la primera versión de Skype.

Tienen un gran potencial en áreas muy diversas, ya que puede desplazarse rápidamente sobre un terreno irregular o accidentado y superar cualquier tipo de obstáculo ofreciendo imágenes o capturando otro tipo de datos a vista de pájaro, gracias a los dispositivos que puede transportar (cámaras, sensores…) sin riesgos para las personas.

Por ello, todos los sectores están haciendo uso de drones en muchas de sus actividades, eligiendo el tipo de dron más adecuado y los sensores que se deben embarcar (cámaras, sensores lidar, etc.) en función del caso de uso y del tipo de datos que se desean medir en cada vuelo.

Adicionalmente, las grandes empresas y gobiernos están promoviendo el uso de drones, ofreciendo soporte a los proyectos para poder entender mejor la regulación y estar al día de la normativa vigente) y creando una herramienta “FLY-AI” que permite entre otras cosas, gestionar de manera eficiente la documentación necesaria para el uso de drones, la aprobación interna de vuelos y la inspección de infraestructuras de manera automática mediante el uso de algoritmos de inteligencia artificial.

La palabra hace referencia, por tanto, a aquellos dispositivos tecnológicos de tamaño reducido que se incorporan a nuestros complementos, prendas o ropa de forma cotidiana, o lo que es lo mismo, aquellos aparatos electrónicos que de alguna forma se “integran” en una parte del cuerpo, interactuando de forma continua con el usuario: gafas inteligentes, smartwatches, pulseras, zapatillas de deporte con GPS incorporado… la lista cada vez es más extensa.

La finalidad de todos estos dispositivos es la de realizar alguna función específica que nos facilita la

vida diaria casi sin darnos cuenta. Y es que, aunque es verdad que los wearables están en auge últimamente, algunos existen desde hace décadas. Es el caso del cronómetro marino, el reloj de pulsera digital o el audífono, dispositivos que perfectamente coinciden con la definición de wearable, aunque a priori no nos lo planteemos.

Este tipo de dispositivos presenta multitud de ventajas. Una de las principales es que, gracias a su tamaño reducido, no tenemos que llevarlos en el bolso, ni en la mano, ni en el bolsillo, como sería el caso del smartphone. Este tipo de tecnología va con el propio usuario, “unida” a su cuerpo como si fuera una parte más de este, es decir, que podemos llevarla, literalmente, puesta.

Otra ventaja de los wearables es que permiten agrupar, en un mismo dispositivo, diferentes herramientas tanto de ocio como de trabajo o de comunicación. Pensemos, por ejemplo, en el caso de los smartwatches, en los que podemos sincronizar nuestra cuenta de correo electrónico, llamadas y mensajes, música o, incluso, nuestro GPS.

Por último, además de ofrecer información al usuario, los wearables también pueden personalizarse. Pueden, por ejemplo, avisarnos de que nuestras pulsaciones son muy altas mientras estamos realizando ejercicio o de que estamos tomando una ruta equivocada cuando conducimos.

El Internet de las cosas (IoT) es el proceso que permite conectar elementos físicos cotidianos al Internet: desde objetos domésticos comunes, como las bombillas, hasta recursos para la atención de la salud, como los dispositivos médicos; también incluyen prendas y artículos personales, como los relojes inteligentes, e incluso los semáforos en ciudades inteligentes.

El término IoT hace referencia a todos los sistemas de dispositivos físicos que reciben y transfieren datos a través de redes inalámbricas con poca intervención humana, lo cual es posible gracias a la integración de dispositivos informáticos en todo tipo de objetos. Por ejemplo, un “termostato inteligente” (por lo general, el término inteligente implica el IoT) recibe datos de la ubicación de su automóvil inteligente mientras conduce, y los utiliza para ajustar la temperatura de su casa antes de que llegue. Esto se logra sin su intervención y el resultado es mejor que si tuviera que ajustar la temperatura de forma manual.

Un sistema de IoT tradicional, como el hogar inteligente descrito anteriormente, funciona enviando, recibiendo y analizando datos de forma permanente en un ciclo de retroalimentación. Según el tipo de tecnología de IoT, las personas o la inteligencia artificial y el aprendizaje automático (IA/ML) utilizan esos datos para realizar análisis casi de inmediato o en cierto tiempo. Piense en el ejemplo del hogar inteligente. Para predecir cuál es el momento óptimo en el que se debe controlar el termostato antes de que llegue a casa, su sistema de IoT puede conectarse a la API de Google Maps y, de este modo, obtener información sobre los patrones de tráfico actuales de su área.

Además, puede utilizar los datos que el automóvil recopila a largo plazo a fin de conocer sus hábitos de conducción. Por otra parte, las empresas de servicios públicos pueden analizar los datos de IoT que recopilan de los clientes con termostatos inteligentes para optimizar el sistema a mayor escala.

El genoma es el conjunto del material hereditario de un organismo, la secuencia de nucleótidos que especifican las instrucciones genéticas para el desarrollo y funcionamiento del mismo y que son transmitidas de generación en generación, de padres a hijos. En él, además de los genes propiamente dichos, se incluyen regiones espaciadoras, regiones reguladoras, restos de genes antaño funcionales y muchas otras secuencias de función o papel todavía desconocido, si es que tienen alguno.

De hecho, en el genoma humano, apenas el 1.5 % del material hereditario tiene una función codificante, es decir, corresponde a lo que solemos entender por genes. Por tanto, el genoma de un organismo es el depositario de la información que permite que cada organismo se desarrolle y responda a las exigencias impuestas por el medio.

Pero, además, el genoma es depositario de los cambios que, a lo largo de la historia de la especie correspondiente y de todas sus antecesoras, han permitido su supervivencia hasta nuestros días. En consecuencia, en el genoma se almacena información de dos tipos: una de inmediata utilidad para el organismo y otra que sirve como registro histórico de éste y de sus ancestros. Ambos tipos de información son explotados por la biología actual, tanto en su vertiente funcional como en la histórica o evolutiva.

Alrededor del genoma se plantean varias cuestiones que conviene aclarar. La primera tiene que ver con su capacidad para determinar total o parcialmente el funcionamiento del organismo. A modo de analogía, podríamos comparar el genoma con los planos de una casa elaborados por un arquitecto en su estudio.

El resultado final depende de muchas decisiones e intermediaciones no siempre previsibles: la disponibilidad de materiales en cada momento, la interpretación realizada por el director de obra, la solución adoptada ante algún imprevisto, las modificaciones introducidas por el propietario, ¡hasta las preferencias estéticas de éstos! Por tanto, el edificio final puede diferir del imaginado inicialmente por el arquitecto que lo planeó, pero estas diferencias se producen más fácilmente en detalles accesorios y menos en los fundamentales.

Igualmente, podemos decir que el genoma de un organismo contiene un conjunto de instrucciones, pero que la forma en que éstas son llevadas a cabo depende a su vez de contingencias ambientales e históricas que pueden llevar a diferencias entre planos (o fragmentos de ellos) en principio iguales. En consecuencia, la naturaleza de las instrucciones genéticas no es completamente determinista en todos los casos, si bien hay una serie de procesos en los que sí se cumple esa perfecta relación entre herencia y expresión final.

Una aplicación móvil es un programa que puedes descargar y al que puedes acceder directamente desde tu teléfono o desde algún otro aparato.

Necesitas un smartphone o algún otro aparato móvil con acceso a internet. No todas las aplicaciones funcionan en todos los aparatos móviles. Cuando compras uno de estos aparatos debes usar el sistema operativo y el tipo de aplicaciones que corresponde a ese aparato. Los sistemas operativos móviles Android, Apple, Microsoft y BlackBerry tienen tiendas de aplicaciones que operan en línea en las cuales puedes buscar, descargar e instalar las aplicaciones.

Algunos comerciantes minoristas también operan tiendas de aplicaciones en internet. Tendrás que usar una tienda que te ofrezca las aplicaciones que funcionen con el sistema operativo de tu aparato.

Algunas aplicaciones son distribuidas gratuitamente por tiendas de aplicaciones. Los creadores de estas aplicaciones pueden ganar dinero de las siguientes maneras: venden un espacio publicitario dentro de la aplicación; ofrecen versiones básicas gratuitas y esperan que te agrade lo suficientemente para pasarse a una versión mejorada de pago; te permiten comprar más funciones de la misma aplicación; se ofrecen gratuitamente para despertar tu interés en otros productos.

La cuarta y última pieza de prueba estructural para la etapa central del Sistema de Lanzamiento Espacial (SLS) de la Nasa se descargó de la barcaza Pegasus en el Centro de Vuelo Espacial Marshall de la agencia espacial en Huntsville, Alabama, el pasado martes.

El tanque oxígeno líquido de unos 21 metros de largo fue fabricado en las Instalaciones de Montaje de Michoud de la Nasa en Nueva Orleans y es estructuralmente idéntico a la versión de vuelo. El tanque de oxígeno líquido es uno de los dos tanques de propelente en la etapa central del cohete que producirá más de dos millones de libras de empuje para ayudar a lanzar la misión Artemisa 1, el primer vuelo de la nave espacial Orión de la Nasa y el SLS, a la Luna.

Mientras el mundo reflexiona sobre el 50 aniversario de las misiones Apolo, la Nasa espera sus próximos saltos gigantes. Una forma en que la Nasa garantizará la seguridad de los astronautas y el éxito de las misiones Artemisa a la Luna en preparación para futuras misiones a Marte es probando las estructuras del cohete SLS.

Con la reciente entrega de la última parte, el tanque de oxígeno líquido, al Centro de Vuelo Espacial Marshall de la Nasa en Huntsville, Alabama, y el inicio de las pruebas en junio de la parte mayor –el tanque de hidrógeno líquido de 45 metros de altura– la Nasa está a más de la mitad de las pruebas estructurales del SLS.

“Este es un momento histórico para el equipo Marshall, así como un hito importante para el programa Artemisa”, dijo el gerente del programa SLS, John Honeycutt.

“Estamos a más de la mitad de la campaña de pruebas más grande en Marshall desde que se probaron aquí las partes del Programa de Transbordadores Espaciales de la Nasa. Con la entrega de la pieza de prueba del tanque de hidrógeno líquido, estamos entrando en la etapa final de las pruebas estructurales del SLS”. SLS, el primer cohete de la agencia construido para enviar humanos al espacio profundo desde el Saturno V, tendrá el poder de llevar a los astronautas a la Luna y finalmente a Marte.

La prueba de las nuevas piezas de hardware, cada vez más complejas, para el primer vuelo de la nave espacial Orión y el SLS de la Nasa, es fundamental para el éxito no solo de la primera misión sino también de las misiones futuras, especialmente para la etapa principal que se utiliza en todas las configuraciones del cohete.

El auge de los smartphones y tablets junto con la entrada de los mercados de aplicaciones han logrado popularizar el uso de aplicaciones entre los usuarios y empresas. El mercado de las apps de usuario es en realidad un mundo de muchos perdedores y unos pocos grandes ganadores.

La mayor parte de los usuarios utiliza unas pocas apps diariamente y son exclusivamente estas las que logran obtener modelos de ingresos realmente atractivos. Pero mientras los desarrolladores de apps compiten por construir negocios rentables los grandes fabricantes de hardware engordan sus cuentas vendiendo terminales.

Gran parte del valor que tienen estos terminales provienen de las apps pero muy pocas apps pueden construir modelos de negocio de interés. Existen cientos de apps para cada cosa.

La mayoría de las empresas que han presentado algún proyecto relacionado con la aviación eléctrica trabajan a la escala de los taxis aéreos dotados de una cabina que puede albergar en su interior entre 2 y 5 pasajeros para realizar desplazamientos urbanos.

Desde Nueva York, Kelekona se desmarca de esta tendencia con la presentación de un eVTOL con capacidad para 40 pasajeros más un piloto en el que se pueden recorrer grandes distancias a alta velocidad. El diseño del fuselaje le permite prescindir de las alas y confiar la sustentación a la aerodinámica.

De entre todos los proyectos que hasta ahora se había presentado, Lilium marcaba el humilde “récord” de ser el que mayor capacidad ofrecía en su cabina, hasta siete asientos (aunque el prototipo de pruebas tenía una capacidad de cinco).

La diferencia con el resto es que no es un dron gigante. Sus motores a reacción totalmente eléctricos situados en cuatro alas fijas además de despegar, pueden girar 180 grados para dirigirlo en cualquier dirección. Gracias a esta capacidad, marca diferencias asegurando velocidades de 300 km/h y distancias de viaje de 300 kilómetros.

Kelekona va mucho más allá con su idea. En su página web asegura vuelos de larga distancia y alta velocidad para sus autobuses eléctricos aéreos, capaces de transportar hasta a 40 pasajeros y un conductor en el interior de su cabina. Como ejemplo dice que será capaz de recorrer los 531 kilómetros que separan Los Ángeles de San Francisco en tan solo una hora.

En caso de emplearse para el transporte de mercancías, la capacidad de cargas de hasta 4,540 kilogramos. El avión eléctrico de Kelekona presenta un fuselaje y un sistema de propulsión preparado para lograr realizar este tipo de operaciones.

Para elevarse utilizará cuatro bancos con dos grandes ventiladores eléctricos cada uno con conductos de aspa de paso variables. Una vez alcanzada la altura de vuelo, estos mismos dispositivos se inclinan hacia adelante para iniciar el vuelo horizontal aprovechando el empuje vectorial de los rotores.

Y aquí es donde Kelekona marca la diferencia. Mientras que otros aviones utilizan grandes y anchas alas para planear, Kelekona confía la sustentación a la forma del cuerpo del avión, que asegura que tiene una superficie capaz de sujetarlo en el aire sin perder eficiencia.

WhatsApp se creó en el 2009, gracias a la idea de uno de sus fundadores, Jan Koum. En primera instancia, él quería crear una aplicación que le permitiera enviar notificaciones a amigos, pero luego la idea cambió y el objetivo cambió a crear una aplicación de mensajería instantánea.

Brian Acton, quien sería el co fundador de la aplicación, se involucró en el proyecto gracias a Koum, quien después de un partido de Frisbee, le pidió que fuera su socio y que juntos pusieran en marcha el proyecto, a lo que él no estaba muy seguro.

Para el otoño de 2009, WhatsApp no tuvo un crecimiento significativo, pero Koum convenció a Acton para que se uniera a él. Tanto Koum como Acton fueron rechazados por trabajos en Facebook. Cuando Acton quiso empezar a buscar un trabajo fijo, porque no veía frutos del proyecto, Koum le dijo que le diera unos meses para que la aplicación tenga mayor demanda y llegaran al éxito.

En octubre de 2009, Acton contactó a varios viejos amigos de Yahoo, contándoles su proyecto y reunió 250,000 dólares en fondos iniciales.

Si hay una aplicación que ha salido reforzada de la crisis de la covid-19 esa es Zoom, la herramienta para realizar videoconferencias. De tener 10 millones de reuniones diarias a finales del año pasado a llegado a superar los 300 millones de sesiones diarias a causa del incremento de las videollamadas 1 a 1, videorreuniones, webinars, etc.

Su fundador, el emprendedor de origen chino Eric S.Yuan, nació en 1970. Con 18 años, siendo estudiante, tenía que viajar durante 10 horas en tren para poder ver a su novia. Eso le llevó a pensar en crear algo como Zoom. En 1997, con 27 años entró a trabajar en la empresa de soluciones de videoconferencia WebEx, una empresa que 10 años después fue adquirida por Cisco, donde se convirtió en responsable de ingeniería de producto.

Después de varias reuniones con clientes, Yuan se percató de que estos tenían quejas del servicio, sobre todo por la calidad del vídeo o fiabilidad. Así, gracias a este feedback en 2011 propuso a su compañía hacer una plataforma de videoconferencias para smartphones, pero su propuesta fue rechazada. No mucho después Yuan decidió dejar la empresa con el fin de crear ese servicio que había ideado cuando era estudiante.

Finalmente consigue incluir a otros 40 compañeros y crean Zoom. La primera beta privada se lanza en mayo de 2012.

Tras cerrar varias rondas de financiación la empresa salió a bolsa en abril del año pasado. Con su impulso durante la crisis del coronavirus sus acciones han duplicado y casi triplicado su valor. Sin embargo, Zoom ha tenido que trabajar a marchas forzadas y mejorar su seguridad antes las críticas y las supuestas vulnerabilidades.

La nube no es un lugar, sino un método de gestión de recursos de TI que sustituye las máquinas locales y los centros de datos privados con infraestructura virtual. En el modelo de computación en la nube, los usuarios acceden a los recursos virtuales de computación, red y almacenamiento que están disponibles en línea a través de un proveedor remoto.

Estos recursos se pueden aprovisionar de manera instantánea, lo que es particularmente útil para las empresas que necesitan escalar verticalmente su infraestructura o reducirla rápidamente en respuesta a una demanda fluctuante.

Existen tres formas principales de computación en la nube como servicio: La forma más básica de la computación en la nube, la infraestructura como servicio (IaaS) brinda a los usuarios acceso a conceptos básicos de infraestructura tales como espacio en servidor, almacenamiento de datos y redes, que pueden aprovisionarse mediante una API.

Este modelo es lo más parecido a la replicación de la funcionalidad de un centro de datos tradicional en un entorno hospedado. La plataforma como servicio (PaaS) ofrece un entorno de desarrollo completo, eliminando la necesidad de que los desarrolladores se ocupen directamente de la capa de infraestructura al implementar o actualizar aplicaciones. Las aplicaciones de software como servicio (SaaS): están diseñadas para usuarios finales, y mantienen detrás de escena todo el desarrollo y el aprovisionamiento de infraestructura.

Las aplicaciones SaaS ofrecen una amplia gama de funcionalidades en la nube: desde aplicaciones empresariales, como programas de procesamiento de texto y hojas de cálculo, hasta CRM, conjuntos de edición de fotografías y plataformas de hospedaje de vídeos.

El machine learning es una disciplina del campo de la inteligencia artificial que, a través de algoritmos, dota a los ordenadores de la capacidad de identificar patrones en datos masivos para hacer predicciones. Este aprendizaje permite a los computadores realizar tareas específicas de forma autónoma, es decir, sin necesidad de ser programados.

El término se utilizó por primera vez en 1959. Sin embargo, ha ganado relevancia en los últimos años debido al aumento de la capacidad de computación y al boom de los datos. Las técnicas de aprendizaje automático son, de hecho, una parte fundamental del Big Data.

Los algoritmos de machine learning se dividen en tres categorías, siendo las dos primeras las más comunes:

Los códigos QR (Quick Response) son códigos de barras, capaces de almacenar determinado tipo de información, como una URL, SMS, E-mail, Texto, etc. Gracias al auge de los nuevos teléfonos inteligentes o Smartphone estos códigos QR están actualmente muy de moda.

Quizás te pueda interesar: Código QR en RD llegó para quedarse: ¿Cuáles sectores económicos lo utilizan?

De acuerdo a información ofrecida en Wikipedia, un código QR (Quick Response Barcode) es un sistema para almacenar información en una matriz de puntos o un código de barras bidimensional creado por la compañía japonesa Denso-Wave en 1994; se caracterizan por los tres cuadrados que se encuentran en las esquinas y que permiten detectar la posición del código al lector.

La sigla “QR” se derivó de la frase inglesa “Quick Response” pues el creador aspiraba a que el código permitiera que su contenido se leyera a alta velocidad. Los códigos QR son muy comunes en Japón y de hecho son el código bidimensional más popular en ese país.

¿Qué tipo de información puede almacenarse en los códigos QR? información de contacto (vCard); una dirección web (URL), por ejemplo al blog, a la web o incluso a tu perfil en Facebook, Twitter, Linkld, Youtube, etc; una dirección de email; un mensaje del tipo SMS; un número de teléfono para realizar una llamada; un texto de hasta 350 caracteres; parámetros de acceso a una red Wifi; datos de un evento para un calendario (día y hora de comienzo/fin, nombre del evento…); y una Geolocalización para verla en un mapa.

La industria eléctrica está cada vez más llamada a una transformación: una evolución de una red centralizada a una más derivada que exija una mayor interacción por parte del consumidor. Aquí es donde entran en juego las Smart Grids, o redes inteligentes, que prometen cambiar el modelo de negocio y su relación con todos sus integrantes, desde las eléctricas al consumidor final.

No cabe duda de que estamos asistiendo a un momento de como nunca antes se ha dado en nuestra sociedad. Sin embargo, a veces podemos ignorar las verdaderas aplicaciones que este progreso digital pueda tener en la vida diaria.

Uno de los ejemplos más atractivos es la aparición de las redes eléctricas inteligentes, una nueva forma de entender y gestionar de manera eficiente la electricidad.

Aunque esta tecnología ya existe desde los años 40, su empleo no deja de aumentar gracias a su abaratamiento y cada vez está más presente en nuestra vida diaria por sus múltiples aplicaciones y ventajas.

RFID son las siglas de Radio Frequency Identification, la tecnología que permite identificar de manera remota e inalámbrica el objeto en el que está 32 colocado un chip mediante una señal de radio. Estos chips o etiquetas son dispositivos muy pequeños con aspecto de pegatinas que pueden adherirse a productos, animales y personas.

Un sistema RFID se basa en un transponder o etiqueta y un lector/escritor, aparte del software de la computadora que conecta la información digital con una base de datos. Transponder: se compone de un circuito integrado (chip) y una antena. El lector emite un campo electromagnético. Cuando el transponder entra en el campo de acción del lector, absorbe su energía.

El transporte marítimo internacional podría sufrir grandes transformaciones próximamente gracias a avances tecnológicos capaces de abaratar costes sin que la cadena logística marítima se resienta. Muy al contrario, su eficiencia podría mejorar de forma significativa, tanto en lo que respecta a su eficacia como en el abaratamiento de costos gracias a ReVolt, un insólito barco que no necesita tripulación todavía en fase de prototipo.

En efecto, si la firma de investigación de transporte DNV GL acaba comercializando su invento, el comercio marítimo podría disponer de cargueros eléctricos autodirigidos, más económicos y sostenibles con el uso de ReVolt, un ejemplo de automatización náutica llevada hasta sus últimas consecuencias con el objetivo de mejorar las transacciones marítimas.

Si bien el transporte marítimo es el modo más antiguo para trasladar mercancías, y actualmente el más empleado a nivel internacional por sus numerosas ventajas, como su gran capacidad, bajos costes, así como la verstatilidad que ofrece, siempre son positivas las mejoras de sus puntos débiles o inconvenientes.

ReVolt consigue evitar la necesidad de que la tripulación tenga que estar largas temporadas en alta mar, así como las altas tasas de mortalidad, dos de sus principales problemas, y lo hace de un modo revolucionario. Simplemente, haciéndola innecesaria.

El programa espacial de China se ha desarrollado rápidamente en los últimos 25 años, a medida que Pekín le ha destinado más fondos para desarrollar los propios sistemas de alta tecnología del país.

Beidou (Osa Mayor, en chino) es considerado un paso significativo pues dará acceso a información de geolocalización tanto a actividades militares como civiles. El Sistema de Navegación por Satélite Beidou, o BDS, se compone por una “constelación” de satelitales que ha sido lanzada en tres fases.

La primera, Beidou-1 constó de tres satélites que operan desde 2000. Beidou-2 mejoró la capacidad desde 2011 con 10 satélites más para cubrir la región Asia-Pacífico. Pero con la adición de 22 más en el programa Beidou-3 a partir de 2015, el sistema alcanzará cobertura global este año y superará al GPS.

El funcionamiento de un HFT se basa en computadoras que compran y venden acciones a una velocidad de vértigo. En algunos mercados como el Nasdaq, permiten a algunos traders ver órdenes 30 milisegundos antes que de mostrarla al resto. Esto les permite sacar ventaja al conocer cuál será la mayor demanda inmediata.

Con cada operación con HFT se ganan centavos, pero esta operación se realiza millones de veces al día. Imaginemos un activo que cotiza en Bolsas diferentes (NYSE, Turquoise y ChiX). Cuando a ChiX le llega una orden que se ejecuta a un precio (y se queda incompleta), los algoritmos de HFT intuyen que se acabará completando dicha orden en otra plataforma como Turquoise y/o NYSE.

Es en ese momento donde el HFT “se mete por medio” anticipándose a comprar las acciones en otra plataforma y poniendo una orden de venta justo antes de que llegue la orden inicial, que comprará irremediablemente al precio que le haya ofertado el HFT. El HFT se lleva una diferencia mínima.

Los HTF tienen la potencia necesaria para recibir la orden cuando llega al ChiX y trasmitirlas a los otros mercados, dando contrapartida a la orden fuerte de compra o venta que saben que llegará.

Para evitar salir perjudicados de esta operativa, los grandes inversores intentan programar sus sistemas para que sus órdenes lleguen en el mismo momento a todos los mercados, evitando así que los HFT puedan beneficiarse de la latencia de las órdenes.

Se supone que los HFT sólo tienen la información de la orden cuando esta llega a un mercado, si no estarían incurriendo en una práctica ilegal llamada “front running”.

La búsqueda convencional de antígenos que puedan ser útiles para la vacunación se ha basado principalmente en el aislamiento e identificación de algunas proteínas mayoritariamente expresadas por M. tuberculosis durante su cultivo en medios sintéticos, y dado que la respuesta protectora es de tipo celular (Th1), se buscan proteínas que tengan la capacidad de estimular in vitro la producción de IFNpor parte de las células T de ratones infectados con la microbacteria.

Sin embargo, algunos inmunógenos que han demostrado cierto éxito como el Ag85, ESAT-6, o CFP-10, no alcanzan los niveles de protección deseables en una vacuna que pudiera eventualmente reemplazar a la BCG, y lo mismo ha ocurrido con las cepas recombinantes de BCG a las que se han introducido o eliminado genes específicos con la intención de aumentar su eficiencia como vacuna viva atenuada en la protección contra la tuberculosis.

La dificultad de evaluar las poco más de 4,000 proteínas codificadas por el genoma de M. tuberculosis como posibles candidatos para vacunación se ha ido reduciendo gracias a la disponibilidad y anotación de la secuencia completa del genoma de M. tuberculosis y otras microbacterias40. Esto ha permitido replantear el problema de la búsqueda de antígenos útiles en vacunación, dejando atrás el reduccionismo extremo y permitiendo un abordaje más integral.

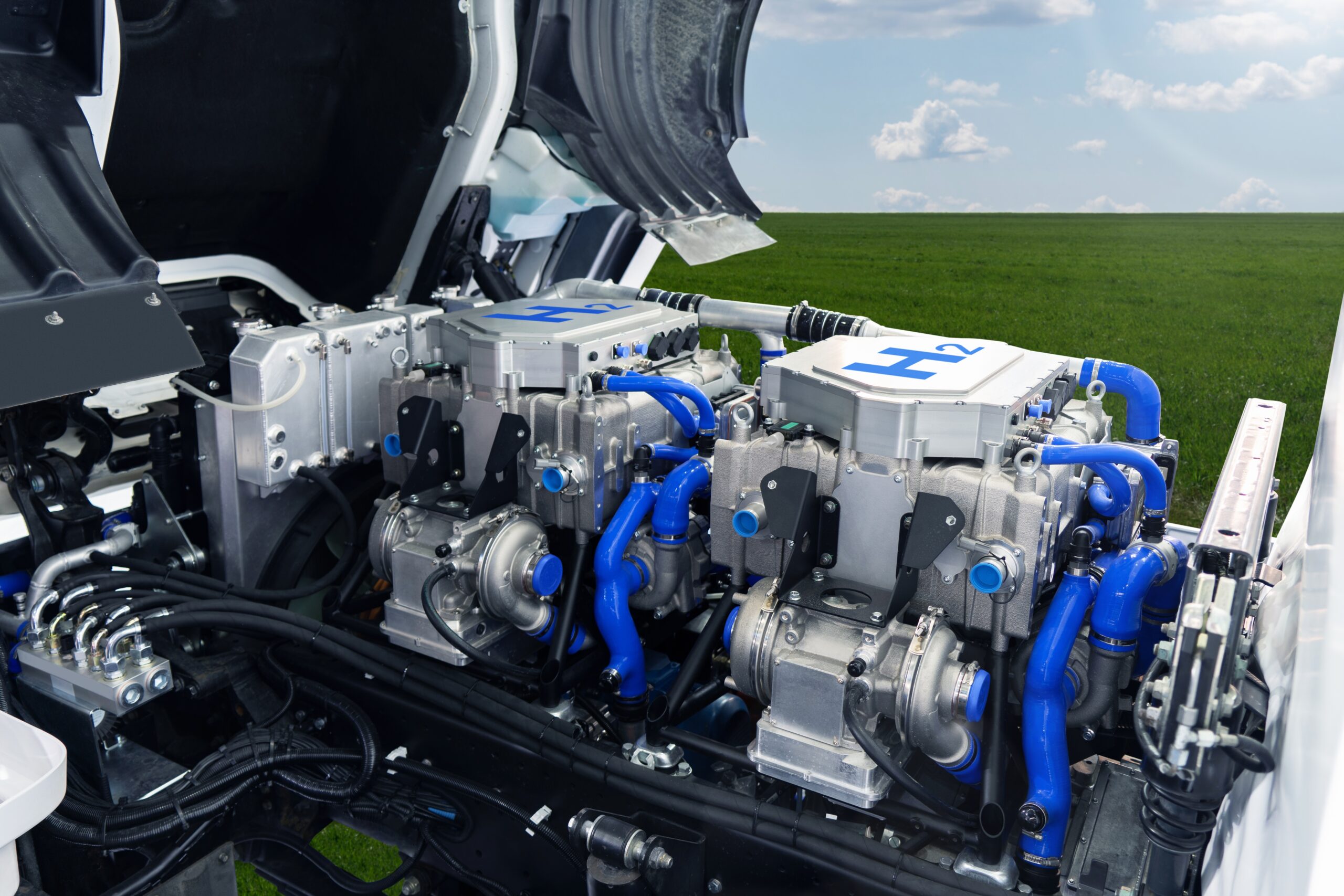

Como sabrás, el hidrógeno es el combustible con mayor relación de energía por unidad de masa, pero su principal diferencia respecto a un motor de gasolina radica en que, en lugar de gases NOx tóxicos, los motores de hidrógeno producen agua como el principal producto de su ciclo de combustión.

Si bien es cierto que debido al calor producido por el motor todavía hay algunas emisiones nocivas de NOx, estas son muy inferiores a las de un motor de gasolina. Por otra parte y, dadas las diferencias entre ambos combustibles, los tipos de relaciones existentes entre aire-combustible, compresión, tiempo y energías de ignición son muy diferentes.

Por ejemplo, el hidrógeno puede tener una relación aire-combustible tan pobre como 180:1, pero una relación de compresión mucho más alta al tener un índice de octano más alto. El motor rotativo Wankel tiene muchos inconvenientes como motor de gasolina, pero la mayoría de estos inconvenientes se convierten en beneficios.

El tráfico aéreo, según la Asociación Internacional de Transporte Aéreo (IATA), se duplicará para 2037. Una nueva realidad que requerirá aproximadamente más de 37,000 nuevos aviones de pasajeros y de carga y más de medio millón de nuevos pilotos. Dado este aumento esperado en los viajes aéreos, se requerirán otras soluciones para apoyar a los pilotos en las operaciones de aeronaves. La compañía europea Airbus espera que la aviación autónoma sea una realidad pronto y sea una alternativa el aumento de la demanda.

Hace solo diez años, la idea de vehículos autónomos en nuestras carreteras parecía una realidad lejana. Y, sin embargo, los rápidos avances en el aprendizaje automático, así como la tecnología de sensores, cámaras y mapas, han avanzado mucho. Pero las tecnologías autónomas no solo son aplicables a los automóviles: también están influyendo en el desarrollo de un vuelo más autónomo. De hecho, la tecnología ya ha reducido el número de pilotos en la cabina de piloto de tres a dos, y el piloto automático se usa habitualmente en muchas fases de vuelo hoy en día.

De esta manera, Airbus explica en comunicado que el desarrollo de tecnologías autónomas avanza rápidamente. El proyecto demostrador de Autonomous Taxi, Take-Off and Landing (ATTOL) es un ejemplo. Este proyecto de Airbus UpNext tiene como objetivo desarrollar y probar algoritmos de visión por computadora que permitirán a una aeronave Airbus rodar, despegar y aterrizar por sí misma, sin la ayuda del aeropuerto o los sistemas satélite.

Recientemente, un equipo de prueba de vuelo de Airbus realizó el primer despegue basado en visión completamente automático, utilizando un avión de prueba de la familia Airbus. Se espera que las secuencias de aterrizaje y rodaje basadas en la visión tengan lugar en algún momento. “Muchas aeronaves ya pueden aterrizar automáticamente”, asegura Sébastien Giuliano, líder del proyecto ATTOL. “Pero dependen de la infraestructura externa como el Sistema de aterrizaje por instrumentos (ILS) o las señales de GPS. ATTOL tiene como objetivo hacer esto posible utilizando únicamente la tecnología de a bordo para maximizar la eficiencia y reducir el costo de la infraestructura”.

Un asistente virtual es uno de los usos más comunes de la inteligencia artificial. Responde a instrucciones y preguntas para ayudar a las personas a completar tareas. Son en esencia una versión digital de un asistente humano.

Los ejemplos más reconocibles son los asistentes de voz de los smartphones y los altavoces inteligentes. Día tras día, estos asistentes ayudan a buscar información en Internet, reproducen música o responden a preguntas básicas.

A medida que las vidas y los hogares de las personas están cada vez más conectados, los asistentes virtuales pueden ayudar a realizar nuevas tareas con mayor facilidad. Los asistentes actuales ya pueden llevar a cabo acciones sofisticadas, como encender la calefacción antes de que llegues a casa, pedir tu comida favorita, entre otras cosas.

La mayoría de internet se encuentra en la deep web: deep web se refiere a todo el contenido que no está indexado por motores de búsqueda como Google, Bing o Yahoo. Por tanto, que no está disponible en páginas con resultados de búsquedas.

Aunque se trata de contenido muy difícil de rastrear y no se puede contabilizar de manera totalmente fiable, se estima que el 96 % de internet se encuentra en la deep web. El 4 % restante corresponde a la surface web. Probablemente la has usado sin saberlo: muchos sitios legales a los se accede cada día no están indexados y pertenecen a ella.

Ejemplos de ello son cuentas bancarias, revistas académicas, páginas que contienen información sanitaria o archivos guardados en Dropbox. Los motivos por los que estos contenidos no están indexados pueden ser muy variados. Los motivos son por seguridad, por ser privados, por estar bloqueados o por ser demasiado antiguos, efímeros o irrelevantes.

Deep web y dark web son cosas diferentes: no todos los contenidos que hay en la deep web son ilegales. De hecho, hay algunas páginas con contenidos constructivos como por ejemplo DuckDuckGo (un buscador de webs convencionales y de enlaces exclusivos de la deep web). La dark web, sin embargo, es una pequeña porción (equivalente al 0.01 %) de la deep web.

Para acceder a la dark web se necesita un conjunto de tecnologías y recursos que hacen que la conexión sea anónima. La finalidad de los contenidos que se encuentran en la dark web suele ser desconocida o ilegal. En ella se encuentra el mercado negro donde se venden armas, drogas y datos personales. Los mercados más importantes de la dark web son Dream, Point y Wall Street Market. Al igual que en las tiendas online convencionales, la reputación de estos sitios se mide mediante comentarios y opiniones de los usuarios.

Desde el año 2017, los deepfakes ganaron protagonismo en internet, ya que comenzaron a circular por la web diferentes vídeos de personalidades famosas que, aunque muy conseguidos, no eran reales. Estos vídeos se pueden hacer de forma muy sencilla, para lo que solo se necesita descargarse una aplicación.

Concretamente, el deepfake es un vídeo manipulado mediante una técnica de inteligencia artificial, la cual permite editar vídeos de personas que parecen reales, aunque no lo son. Es posible, de este modo, reemplazar la cara de una persona del vídeo por otro rostro completamente diferente.

Aunque puede parecer divertido, y lo es si no se usa con malas intenciones, estos deepfakes pueden ocasionar problemas políticos, judiciales o sociales, cuando se emplean estas técnicas con el objetivo de dañar la imagen de otra persona.

El 23 de octubre de 2001 se presentaba el primer reproductor multimedia portátil comercializado por la compañía norteamericana Apple Inc. Gracias a su campaña de publicidad, en la que destacaban los auriculares blancos sobre fondos de colores, ha sido uno de los mayores éxitos de ventas en este siglo.

El dispositivo almacena el material multimedia, como la música o las fotos, en un disco duro interno, mientras que los modelos posteriores hacen uso de una memoria flash que permite su menor tamaño. Posteriormente se lanzaron el iPod Touch, el iPod Nano, el iPod Shuffle y el iPhone, que incluye un iPod integrado.

Antes de que la masificación de los teléfonos inteligentes convirtiera al iPod en un accesorio de nicho, se vendieron al menos 200 millones de unidades, algo clave para que Apple regresara al torneo de los pesos pesados de las grandes tecnológicas.

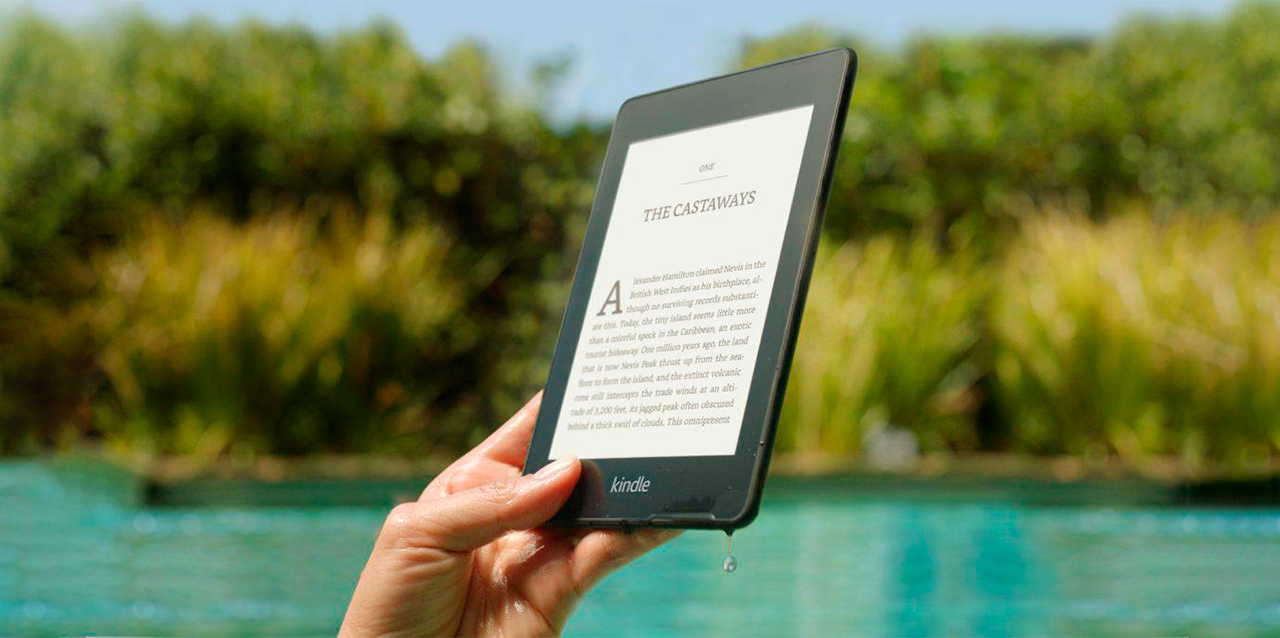

Lanzado en noviembre de 2007, Amazon Kindle se exhibió en la revista NewsWeek. Salió a la venta en Amazon.com el 19 de noviembre y se agotó en unas horas y fue inmediatamente apodado “el iPod de la lectura”.

El Kindle original lanzado con una pantalla E Ink de 6 pulgadas, ofrecía una conexión inalámbrica gratuita a través de la red EV-DO de Sprint, en el nuevo Whispernet anunciado por Amazon.

Sin embargo, no había control táctil, por lo que el Kindle ofrecía un teclado completo, botones de navegación y un diseño peculiar en forma de cuña con el objetivo de mejorar su sujeción. También ofrecía una toma de altavoz y auriculares, y almacenamiento de tarjeta SD expandible.

Debido a que la navegación por la página era difícil, presentaba una segunda pantalla con una rueda de desplazamiento para ayudar a facilitar las selecciones en la pantalla. Eso era necesario porque la pantalla de E Ink era demasiado lenta para actualizarse para brindar una experiencia de navegación natural.

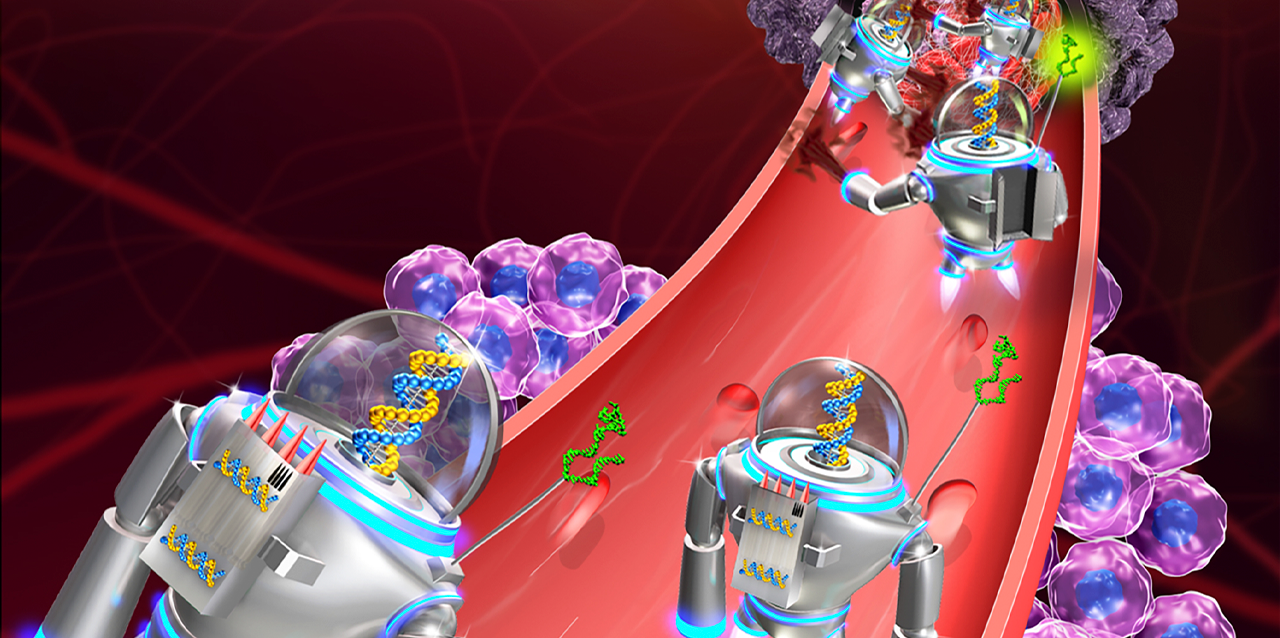

Las transformaciones del futuro están del lado de la biorobótica, por lo tanto, los nanorobots prometen ser el paso a la próxima evolución humana.

La nanotecnología consiste en el estudio, diseño, creación, síntesis, manipulación y aplicación de materiales, aparatos y sistemas funcionales a través del control y la explotación de fenómenos y propiedades de la materia a nanoescala, es decir, medidas extremadamente pequeñas.

El desarrollo de esta disciplina se produce a partir de las propuestas del físico Richard Feynman, ganador del premio nobel de física en 1965, donde a partir de sus sueños de ciencia y ficción nace la idea de crear nanobots o ensambladores. Los nanorobots son fabricaciones de máquinas con diferentes dimensiones tan diminutas que existe la capacidad de manipularla. Estos tienen la capacidad de viajar dentro del ser humano con la intención de atacar algunas enfermedades, al igual que realizar otras funciones en el medio ambiente.

Existen dos tipos de nanobots:

La nanotecnología es un campo que todavía se encuentra en desarrollo y existen distintos caminos por recorrer, uno de los más esperanzadores en un futuro para el área de la salud.

En China ya se están probando drones para pasajeros, que pueden realizar viajes de hasta 21 minutos a una velocidad de entre 80 y 120 kilómetros y a una altura de hasta 1,000 metros. Antes de iniciar el viaje, se hace una comprobación técnica de las hélices y se prepara todo en una sala de control, desde donde se dirige y conduce el dron, que destaca por ser autónomo y en el que hay espacio para dos pasajeros que deben ajustarse el cinturón antes de despegar.

El dron, desarrollado por una compañía en Guanzhou –la primera compañía en hacerlo en el mundo–-, ya se probó en diciembre del año pasado con pasajeros dentro y ahora está pendiente de la autorización final del Gobierno chino, por lo que en tan solo unos meses los taxis voladores podrían convertirse en una realidad en el país.

La compañía emplea redes 4G para monitorizar dron es en todo el país y puede controlar hasta 10.000 aparatos sin problema desde las tres salas de control que hay en China, según explica a RTVE el subdirector de la empresa, Xu Huaxiang, quien ha añadido que estos drones servirán para aliviar el tráfico en las grandes ciudades y para los turistas.

Poner atención; concentrarse en una idea; imaginar o realizar movimientos tan sutiles del cuerpo, como abrir o cerrar los ojos genera actividad bioeléctrica, la cual puede ser representada como una onda.

Especialistas del Instituto de Investigaciones Matemáticas Aplicadas y en Sistemas (IIMAS)-UNAM están comenzando a utilizar esta actividad bioeléctrica para activar dispositivos como sillas de ruedas y prótesis, entre otros, de tal forma que se puedan controlar con la mente.

“Inicialmente estamos trabajamos con un dispositivo comercial de bajo costo, formado por una especie de diadema con 16 sensores, que colecta, amplifica y filtra las señales a través del cuero cabelludo, las cuales varían según la zona del cerebro y la información procesada en cada momento; es decir, al imaginar algo en particular, por ejemplo, una acción, un recuerdo o un objeto, se genera un patrón, mientras más definido esté el pensamiento será más fácil distinguirlo y procesarlo, por eso es importante llevar a cabo ejercicios de entrenamiento”, explica Hernando Ortega Carrillo, líder de este proyecto.

El dispositivo ya está siendo probado con una mano robótica y en una silla de ruedas, ambos fabricados en el Instituto; sin embargo, el equipo investigador sigue trabajando en su optimización, aplicando ingeniería inversa para entender y mejorar su funcionamiento.

A través de un lenguaje de fácil aprendizaje se puede establecer una comunicación ágil entre la mente y los dispositivos electrónicos.

La red 5G es la evolución de las redes inalámbricas 4.5G (LTE), en la que además de conseguir una menor latencia (tiempo de respuesta al enviar y recibir paquetes de datos), se aumenta la capacidad de comunicación simultánea entre dispositivos, así como la velocidad de transmisión, llegando a velocidades teóricas en un entorno ideal de hasta 10Gbps (100 veces mayor que la tecnología actual).

De igual forma, con esta tecnología, abrimos la posibilidad de trabajar con dispositivos IoT. Gracias a él, proveemos de alta capacidad de transmisión de datos a un sinfín de dispositivos con los que convivimos a diario y que nos permitirán recibir información a tiempo real de todo lo necesario para interactuar de forma remota en este mundo globalizado en el que vivimos.

Quizás te pueda interesar: El mapa de 5G, ¿en qué países ya se implementa esta tecnología?

¿Cuáles son las principales ventajas que plantea? Ancho de banda 100 veces mayor que la tecnología actual (LTE), podremos ver en tiempo real a través de Internet un video en 8K, sin sufrir las eternas interrupciones para llenar el buffer; reducción de latencia a 1 milisegundo, ideal para aplicaciones de telemedicina (donde la latencia es imprescindible) por no hablar de los juegos en red; mayor capacidad de concurrencia de dispositivos conectados simultáneamente, podremos plantearnos tener una ciudad inteligente con sus semáforos, farolas, contenedores de basura, papeleras…

Un equipo de investigadores del Instituto Salk de Estudios Biológicos, dirigido por Juan Carlos Izpisúa Belmonte, ha conseguido revertir las marcas del envejecimiento en células humanas y en ratones mediante la expresión intermitente de un conjunto de genes característicos de las células madre embrionarias.

El envejecimiento es uno de los principales factores de riesgo para el desarrollo de enfermedades como el cáncer, la diabetes, condiciones neurodegenerativas o diversas enfermedades cardiovasculares. Conforme envejecemos los mecanismos responsables de mantener la maquinaria molecular de nuestras células, tejidos y órganos se deterioran, lo que afecta a las diferentes funciones del organismo y repercute gravemente en el estado de salud.

Estudios previos habían demostrado que algunas características celulares típicas del envejecimiento pueden mejorarse durante la reprogramación celular in vitro, proceso que permite desdiferenciar células adultas en células pluripotenciales con capacidad para convertirse en otros tipos celulares.

Sin embargo, se desconocía si se podía inducir el mismo efecto in vivo, en un organismo completo. La reprogramación celular de células diferenciadas a un estado similar al de las células madre embrionarias se lleva a cabo mediante la expresión forzada de cuatro genes, Oct4, Sox2, Klf4 y c-Myc, conocidos como los factores Yamanaka.

El conjunto de estos cuatro factores de transcripción induce los cambios de expresión génica y la remodelación epigenética necesarios para revertir el proceso de diferenciación y devolver la célula a un estado pluripotencial.

Spotify nació en 2008 como un reproductor de música en streaming para ordenadores y sólo estaba disponibles en Suecia, Finlandia, Francia, Reino Unido y España. Los usuarios podían acceder a millones de canciones sin tener que descargarlas.

En 2011 la compañía aterrizó en EE. UU compitiendo de cerca con iTunes, a quien de momento gana en usuarios activos. Aun así, el gran salto lo dio cuando la plataforma pudo albergar aplicaciones de terceros, Spotify Platform, integrando revistas como Rolling Stone, teniendo su propio canal o aplicaciones como Tunewiki para ver las letras de sus propias canciones.

A la misma vez se introduce la posibilidad de que los usuarios puedan ver y compartir lo que están escuchando con ellos. Spotify se reinventa y elimina la limitación de 20 horas semanales de escucha. ¿El precio? Añadir publicidad entre canciones, limitaciones con la reproducción aleatoria y el hecho de que puedas escuchar música sin conexión.

En pocas palabras, si 4K es cuatro veces la resolución de Full HD, entonces, 8K es cuatro veces la resolución de 4K, y 16 veces la resolución de Full HD. ¿Es una característica valiosa en la configuración de entretenimiento en el hogar, y reemplazará a 4K pronto? Vamos a profundizar en 8K TV y encontrar esas respuestas.

Si usas matemáticas básicas, puede parecer que 8K proporcionaría el doble de resolución que 4K, pero ese no es el caso. Como estamos hablando de dos dimensiones: líneas horizontales y líneas verticales, en realidad son 16 veces los píxeles de HD y cuatro veces los píxeles de 4K. La resolución 8K equivale a 7,680 x 4,320 pixeles, o 33 millones de píxeles (33,117,600, para ser exacto), en lugar de 4K que contiene 3,840 x 2,160 (8,294,400 píxeles).

Para visualizarlo más fácilmente, imagina cuatro televisores 4K colocados en una cuadrícula de dos por dos o 16 televisores 1080p en una cuadricula de cuatro por cuatro. Esos son muchos píxeles.

Otras tecnologías, como el HDR, alto rango dinámico, a veces pueden hacer una diferencia más visible, especialmente desde la distancia, ya que los televisores muestran una imagen más brillante y colorida con HDR. Sin embargo, 8K es absolutamente notable en pantallas más grandes, y cuanto más te acerques, mejor se verá.

Travis Kalanick y Garrett Camp fundaron en 2009 Uber, pero bajo el nombre de UberCab. La primera versión de la app, que actualmente es conocida como el prototipo o una versión beta, fue desarrollada por Garrett Camp, Oscar Salazar y Conrad Whelan.

En 2011, la compañía alcanzó un valor de 60 millones de dólares luego de varias inversiones de personas interesadas en el proyecto. También se logra la internacionalización con su incursión en Francia, todo gracias a una una inversión de Jeff Bezos (fundador de Amazon).

El 2011 también significó para Uber su salida de San Francisco para llegar a una de sus ciudades más lucrativas, Nueva York. Ya con una empresa sólida, Uber decide sacar en julio de 2012 su innovador servicio Uber X, un proyecto de transporte a bajo costo que permitía a las personas conducir bajo el nombre de la empresa con su propio auto.

Fue con la llegada de Uber X que comenzó el éxito. En 2013 la compañía inauguró sus servicios en India y algunas ciudades de África, logrando así una presencia en 35 ciudades alrededor del mundo. Ese mismo año, se recibió una inversión de 258 millones de dólares por parte de Google Ventures, hecho que ayudó a que Uber cerrara el año con un valor de 3 mil 760 millones de dólares.

Escrito por Carlos Arturo Guisarre; adaptado por Paola Ferreras.

Suscríbete a la revista y regístrate a nuestros newsletters para recibir el mejor contenido en tu buzón de entrada.